La inteligencia artificial (IA) se ha expandido rápidamente a aplicaciones clínicas, como la imagenología y otros diagnósticos, la escritura ambiental y el apoyo a la toma de decisiones.

Fuente: JAMA Network

Nota: Epicrisis es el órgano oficial de comunicación del Colegio Médico Colombiano. La opinión y conceptos personales expresados en los artículos firmados por un tercero no reflejan la posición de Epicrisis o del Colegio Médico Colombiano-CMC-.

Ha traído consigo tanto beneficios potenciales como riesgos importantes. En EE. UU., no está claro quién tiene la responsabilidad de establecer las reglas, validar los modelos y, en última instancia, pagar cuando las cosas salen mal.

En este contexto, la Comisión Conjunta (TJC, el principal acreditador hospitalario de EE. UU.) se ha asociado con la Coalición para la IA en Salud (CHAI, un grupo liderado por médicos que incluye a la industria y a las partes interesadas).

Juntos, han publicado una nueva guía sobre el uso responsable de la IA en la atención médica, que se basa en declaraciones previas de numerosos grupos, incluida la Asociación Médica Estadounidense.

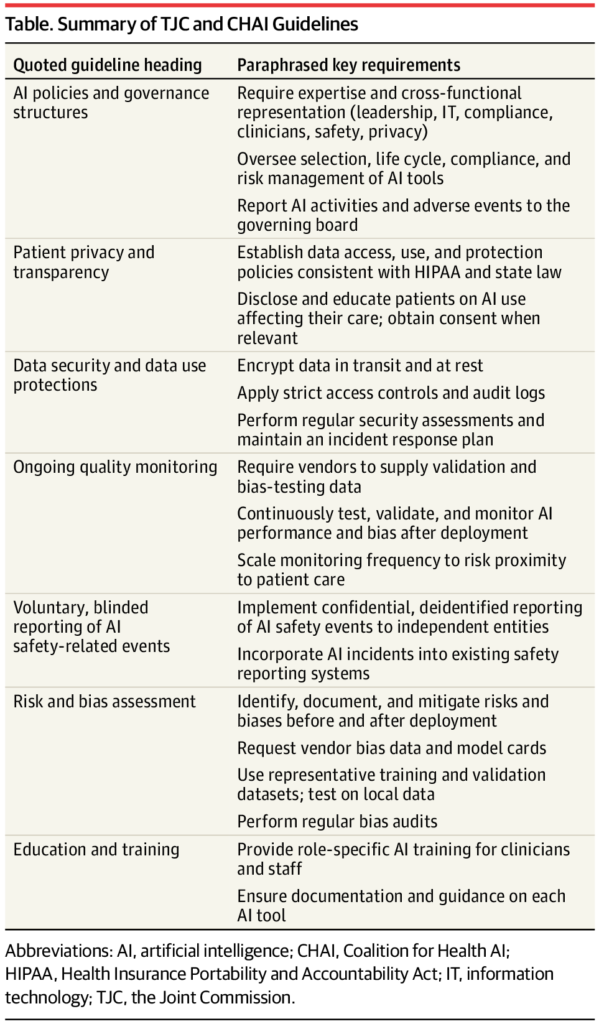

Las recomendaciones principales incluyen establecer comités multidisciplinarios de gobernanza de IA, validar modelos en datos de pacientes locales y flujos de trabajo antes de la implementación e instituir un monitoreo continuo posterior a la comercialización para detectar desviaciones, degradación del rendimiento o sesgo 1 ( Tabla ).

La guía de CHAI y TJC deja muchos detalles a las organizaciones de atención médica para que los implementen.

Por ejemplo, parece adoptar una línea sorprendentemente dura en la interacción con los pacientes, aconsejando que “cuando sea apropiado, se debe notificar a los pacientes cuando la IA impacta directamente en su atención… Donde y cuando sea relevante, se debe obtener el consentimiento”.1

Los médicos generalmente no revelan ni piden el consentimiento para cada dispositivo tecnológico que pueden implementar (por ejemplo, este bisturí frente a ese otro).

¿Es la IA de diferente tipo? ¿Todo informe radiólogo necesita una exención de responsabilidad sobre el uso de la IA o incluso el consentimiento previo para ese uso? ¿Qué deben hacer los pacientes con dichas revelaciones?2 Las preguntas difíciles persisten en las palabras de la guía: apropiado y relevante .

Para las instituciones de atención médica, el cumplimiento de las nuevas directrices requerirá estructuras de gobernanza, paneles de monitoreo, mecanismos de reporte de incidentes y documentación1.

Estas medidas son paralelas a los marcos de calidad y seguridad establecidos (como requisitos de acreditación, reporte de eventos de seguridad del paciente y programas de gestión de riesgos) para que la supervisión de la IA pueda integrarse en estructuras ya familiares para los hospitales.

Sin embargo, el cumplimiento probablemente requerirá nuevas inversiones sustanciales. TJC y CHAI instan a cada hospital a establecer una estructura de gobernanza formal para la IA, con políticas y procedimientos para seleccionar, implementar y supervisar las herramientas de IA.

Esta función requerirá ejecutivos con la experiencia adecuada en IA para reunir y dirigir un comité multidisciplinario de IA. Quizás uno de los elementos que consume más recursos es el monitoreo continuo del rendimiento y los resultados de la IA.3

El hospital debe medir la precisión, los errores o los eventos adversos asociados con las recomendaciones de IA y el rendimiento a lo largo del tiempo, incluyendo la equidad y el sesgo en las poblaciones de pacientes.

Aunque los grandes centros académicos tienen la capacidad de validar rigurosamente las herramientas de IA, casi dos tercios de los hospitales de EE. UU. tienen menos de 100 camas y muchos operan en entornos rurales con limitaciones de recursos (por ejemplo, falta de cobertura ampliada de Medicaid).4

Es más probable que un hospital comunitario más pequeño adquiera tecnología lista para usar y confíe en las garantías de los proveedores. Realizar una auditoría de sesgo independiente y un análisis de riesgos podría estar más allá de su experiencia y recursos.

Estos desafíos explican por qué las investigaciones muestran que, si bien el 61 % de los hospitales que utilizan IA habían realizado una validación local de precisión, solo el 44 % evaluó sus modelos en busca de sesgos utilizando sus propios datos.4 Para muchos hospitales, las directrices de CHAI y TJC pueden ser ambiciosas.

¿Cuáles son las consecuencias del incumplimiento? TJC no ha incorporado (aún) estas normas a sus requisitos de acreditación, que son un requisito previo para facturar a las aseguradoras públicas y privadas. Por ahora, es plausible que estas directrices afecten la responsabilidad.

Los tribunales han obligado a los médicos y a las organizaciones de atención médica a cumplir con un estándar de atención razonable, en parte basado en la guía convincente de organizaciones de renombre, como TJC y CHAI.

Un médico demandado podría usar estas directrices para enfatizar que la responsabilidad recae en las organizaciones de atención médica, reduciendo o evitando así la responsabilidad del médico.3

Por otro lado, los hospitales se encuentran en una situación difícil si no pueden cumplir con las onerosas directrices. Aun así, los tribunales pueden tener en cuenta las limitaciones de recursos al asignar la responsabilidad por negligencia.

Además de las preocupaciones distributivas que afectan a las organizaciones sanitarias, también existen preocupaciones más amplias sobre la eficiencia. ¿Tiene sentido que cada una de las miles de organizaciones sanitarias realice todo este trabajo de forma independiente?

Por el contrario, un sistema racional podría encargar gran parte de este trabajo de una sola vez y con autoridad. Asimismo, no esperamos que cada hospital realice una evaluación de novo de la competencia de cada médico; en cambio, los comités de personal hospitalario dependen de las agencias estatales de licencias. Sin embargo, actualmente no existe una agencia de este tipo para la IA.

Las directrices de TJC y CHAI buscan aprovechar al máximo un mundo ya fragmentado, en el que el gobierno federal estadounidense no ha dado un paso al frente para proporcionar un mecanismo integral que evalúe los servicios de IA utilizados en el comercio interestatal y financiados a través de programas federales de atención médica.5

Cabe destacar que CHAI también ha propuesto subsanar esta deficiencia mediante la creación de una red de laboratorios de certificación privados para verificar algoritmos, de modo que las organizaciones de atención médica puedan confiar en ellos.

La administración Biden se alineó con este enfoque, pero la administración Trump se opone. La preocupación radica en que una coalición privada, con una fuerte presencia de la industria, podría consolidar a los proveedores dominantes y actuar como un regulador de facto.6

En parte, la brecha federal se debe a la decisión de la Administración de Alimentos y Medicamentos de los Estados Unidos (FDA) de centrar su aplicación en las tecnologías de IA automatizadas cuando no hay un médico involucrado.

Se necesitaría un presupuesto mucho mayor de la FDA para cubrir todas las tecnologías de IA para el cuidado de la salud, y la industria tendría que invertir considerablemente para satisfacer las demandas científicas que la FDA requeriría.

Dichas inversiones podrían ahorrar dinero al sistema de salud en general al reducir las redundancias locales y mejorar el rendimiento general. A finales de septiembre de 2025, la FDA solicitó comentarios públicos sobre un posible nuevo enfoque para “enfoques prácticos para medir y evaluar el rendimiento de los dispositivos médicos con IA en el campo, incluyendo estrategias para identificar y gestionar las desviaciones del rendimiento, como la detección de cambios en la entrada y la salida”.7

En definitiva, TJC y CHAI han creado un marco importante que busca mejorar la seguridad y los resultados de los pacientes, reforzar la protección de datos, aumentar la confianza y la eficiencia operativa.

Sin un sistema unificado para evaluar los productos de IA, los hospitales seguirán asumiendo responsabilidades fragmentadas, lo que generará ineficiencias y ampliará las disparidades en seguridad, calidad y,vpotencialmente, responsabilidades.

Referencias

- Comisión Conjunta. Comisión Conjunta y Coalición para la IA en la Salud (CHAI), uso responsable de la IA en la atención médica (RUAIH). Consultado el 31 de octubre de 2025.

https://digitalassets.jointcommission.org/api/public/content/dcfcf4f1a0cc45cdb526b3cb034c68c2?v=3edb8a95 - Robertson C, Woods A, Bergstrand K, Findley J, Balser C, Slepian MJ. Actitudes de diversos pacientes hacia la inteligencia artificial (IA) en el diagnóstico. PLOS Digit Health . 2023;2(5):e0000237. doi:

10.1371/journal.pdig.0000237 - Price WN II, Gerke S, Cohen IG. Posible responsabilidad de los médicos que utilizan inteligencia artificial. JAMA . 2019;322(18):1765-1766. doi: 10.1001/jama.2019.15064

- Nong P, Adler-Milstein J, Apathy NC, Holmgren AJ, Everson J. Uso actual y evaluación de la inteligencia artificial y los modelos predictivos en hospitales estadounidenses. Health Aff (Millwood) . 2025;44(1):90-98. doi: 10.1377/hlthaff.2024.00842

- Babic B, Gerke S, Evgeniou T, Cohen IG. Algoritmos para el bloqueo regulatorio en medicina. Science . 2019;366(6470):1202-1204. doi: 10.1126/science.aay9547

- Lector R. Trump a los gigantes de la salud y la tecnología: La IA no es su “cártel”. Politico. Publicado el 1 de octubre de 2025. Consultado el 31 de octubre de 2025.

https://www.politico.com/news/2025/10/01/trump-ai-artificial-intelligence-regulation-hhs-00590902 - Solicitud de comentarios públicos: medición y evaluación del rendimiento de dispositivos médicos con inteligencia artificial en el mundo real. Administración de Alimentos y Medicamentos de EE. UU. (FDA). Actualizado el 30 de septiembre de 2025. Consultado el 31 de octubre de 2025.

https://www.fda.gov/medical-devices/digital-health-center-excellence/request-public-comment-measuring-and-evaluating-artificial-intelligence-enabled-medical-device

Deja un comentario